Deseja otimizar seu arquivo WordPress robots.txt? Não tenho certeza por que e como o arquivo robots.txt é importante para o seu SEO? Nós temos você coberto. Neste artigo, mostraremos como otimizar seus WordPress robots.txt para SEO e ajudá-lo a entender a importância do arquivo robots.txt.

Recentemente, um usuário nos perguntou se eles precisam de um arquivo robots.txt e qual é a importância dele? O arquivo robots.txt do seu site desempenha um papel importante no desempenho geral de SEO do seu site. Ele basicamente permite que você se comunique com os motores de busca e deixe-os saber quais partes do seu site eles devem indexar.

Eu realmente preciso de um arquivo Robots.txt?

A ausência de um arquivo robots.txt não impedirá os mecanismos de pesquisa de rastrear e indexar seu site. No entanto, é altamente recomendável que você crie um. Se você deseja enviar o sitemap XML do seu site para os motores de busca, então é onde os motores de busca procurarão seu sitemap XML, a menos que você o tenha especificado nas Ferramentas do Google para webmasters.

Nós recomendamos que, se você não tiver um arquivo robots.txt no seu site, você criará um imediatamente.

Onde está o arquivo Robots.txt? Como criar um arquivo Robots.txt?

O arquivo Robots.txt geralmente reside na pasta raiz do seu site. Você precisará se conectar ao seu site usando um cliente FTP ou usando o gerenciador de arquivos cPanel para visualizá-lo.

É como qualquer arquivo de texto comum e você pode abri-lo com um editor de texto simples, como o Bloco de notas.

Se você não possui um arquivo robots.txt no diretório raiz do seu site, você sempre pode criar um. Tudo o que você precisa fazer é criar um novo arquivo de texto em seu computador e salvá-lo como robots.txt. Em seguida, basta carregá-lo na pasta raiz do seu site.

Como usar o arquivo Robots.txt?

O formato do arquivo robots.txt é realmente bastante simples. A primeira linha geralmente nomeia um agente de usuário. O agente do usuário é, na verdade, o nome do botão de busca com o qual você está tentando se comunicar. Por exemplo, Googlebot ou Bingbot. Você pode usar asterisco * para instruir todos os robôs.

A próxima linha segue as instruções Permitir ou Desativar para os motores de busca, para que eles saibam quais partes você quer indexar, e quais você não quer indexar.

Veja um exemplo de arquivo robots.txt:

Agente de usuário: * Permitir: / wp-content / uploads / Não permite: / wp-content / plugins / Não permite: /readme.html

Neste exemplo, o arquivo robots.txt para o WordPress, instruiu todos os robôs a indexar nosso diretório de upload de imagens.

Nas próximas duas linhas, nós os impedimos de indexar nosso diretório de plugins do WordPress e o arquivo readme.html.

Otimizando seu arquivo Robots.txt para SEO

Nas diretrizes para webmasters, o Google aconselha os webmasters a não usar o arquivo robots.txt para esconder conteúdo de baixa qualidade. Se você estivesse pensando em usar o arquivo robots.txt para impedir o Google de indexar sua categoria, data e outras páginas de arquivo, isso pode não ser uma escolha sábia.

Lembre-se, o propósito do robots.txt é instruir os robôs sobre o que fazer com o conteúdo que eles rastreiam em seu site. Isso não impede que os robôs rastreiem seu site.

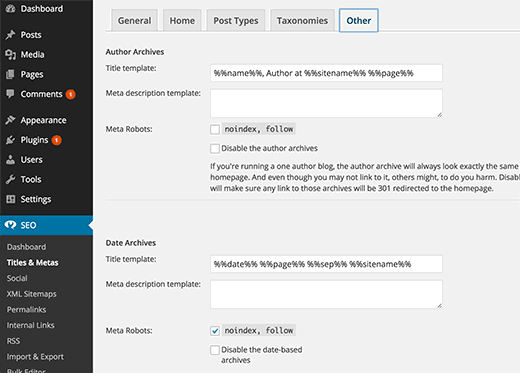

Existem outros plugins do WordPress que permitem adicionar meta-tags como nofollow e noindex nas suas páginas de arquivo. WordPress SEO plugin também permite que você faça isso. Não estamos dizendo que você deveria ter suas páginas de arquivo deindexed, mas se você quisesse fazê-lo, então é a maneira correta de fazê-lo.

Você não precisa adicionar sua página de login, diretório de administração ou página de registro do WordPress para robots.txt porque as páginas de login e registro têm tag de noindex adicionada como meta tag pelo WordPress.

É recomendável que você não permita o arquivo readme.html no seu arquivo robots.txt. Este arquivo readme pode ser usado por alguém que está tentando descobrir qual versão do WordPress você está usando. Se este fosse um indivíduo, então eles podem acessar o arquivo simplesmente navegando para ele.

Por outro lado, se alguém está executando uma consulta maliciosa para localizar sites do WordPress usando uma versão específica, então esta etiqueta de desativação pode protegê-lo contra esses ataques em massa.

Você também pode desativar seu diretório de plugins do WordPress. Isso fortalecerá a segurança do seu site se alguém estiver procurando por um plugin vulnerável específico para explorar um ataque em massa.

Adicionando o seu Sitemap XML ao arquivo Robots.txt

Se você estiver usando o plugin SEO WordPress da Yoast ou algum outro plugin para gerar seu sitemap XML, seu plugin tentará adicionar automaticamente suas linhas relacionadas ao sitemap no arquivo robots.txt.

No entanto, se ele falhar, seu plugin irá mostrar-lhe o link para seus Sitemaps XML, que você pode adicionar ao seu arquivo robots.txt manualmente assim:

Sitemap: http://www.example.com/post-sitemap.xml Sitemap: http://www.example.com/page-sitemap.xml

O que um arquivo Ideal Robots.txt deve parecer?

Honestamente, muitos blogs populares usam arquivos robots.txt muito simples. Os seus conteúdos variam, dependendo das necessidades do site específico:

Agente de usuário: * Não permitir: Sitemap: http://www.example.com/post-sitemap.xml Sitemap: http://www.example.com/page-sitemap.xml

Este arquivo robots.txt simplesmente diz a todos os bots para indexar todo o conteúdo e fornece os links aos sitemaps XML do site.

local

Agente de usuário: * Permitir: /? Display = wide Permitir: / wp-content / uploads / Não permite: / wp-content / plugins / Não permite: /readme.html Não permitir: / referir / Sitemap: http://www.site.com/post-sitemap.xml Sitemap: http://www.site.com/page-sitemap.xml Sitemap: http://www.site.com/deals-sitemap.xml Sitemap: http://www.site.com/hosting-sitemap.xml